- 総合TOP

- 宇宙

- AI

- ロボット

- WEB3・メタバース

ものごとを知覚し、自律的に決断し、学習することができる現在のロボット。人間の決断や感情にも大きな影響を与える存在です。新しい技術には必ず検討すべきことがありますが、その中でも特に考えるべき点が多いのが、ロボットやAIだと指摘されています。そうしたニーズから提唱されるようになった「ロボット倫理学」について、その意義とポテンシャルを探る本連載。

第2回は有名な「トロッコ問題」等を交えて、ロボットが人命に関わる決断を迫られた時の判断について考えます。自動運転車など、将来的にあらゆる自動化が進む中で、避けることのできない問題です。

大学教員、ライター、編集ディレクター

博士(文学)。南山大学総合政策学部などで准教授、特任教授を歴任。現在は信州大学グローバル化推進センター非常勤講師。専門は日本語学、日本語教育。高等教育の他、文部科学省、外務省、厚生労働省などのプログラムに参画し、日本語教師育成、教材開発、辞書編集、リカレント教育、外国人就労・定着支援などに携わる。2019年からライター、編集ディレクターとしても働いている。

横内美保子

SFの世界が現実に? アシモフのロボット工学三原則と道徳機械(モラルマシーンズ)

アイザック・アシモフの古典的SF小説『われはロボット(I, ROBOT)』が「ロボットの世界」への入り口になったという人も多いのではないでしょうか。

小説の扉に掲げられている「ロボット工学の三原則」は、ロボット工学だけでなく、ロボット倫理学にも大きな影響を与えてきました。その三原則が、現在は自動運転の文脈でも議論されています。

それは、自動運転車の倫理アルゴリズムをどう確立していくかという問題です。倫理が備わった「道徳機械(モラルマシーンズ)」を実現させることはできるのでしょうか。

ロボット工学三原則と倫理的規範

「道徳機械」とは、「倫理的な規則に従って行動を決定・修正する能力を持つロボット」を指します。*1

その実現可能性について考えるとき、アシモフの『われはロボット』は示唆に富んでいます。

ロボット工学三原則とは

「ロボット工学の三原則」(以下、「三原則」)は、次のようなものです。 *2

第一条 ロボットは人間に危害を加えてはならない。また、その危険を看過することによって、人間に危害を及ぼしてはならない。

第二条 ロボットは人間にあたえられた命令に服従しなければならない。ただし、あたえられた命令が、第一条に反する場合は、この限りではない。

第三条 ロボットは、前掲第一条および第二条に反するおそれのないかぎり、自己をまもらなければならない。

―『ロボット工学ハンドブック』、 第五十六版、西暦二〇五八年

ちなみに、アシモフは1985年に、「人間(a human being)」を「人類( humanity)」に言い換え、以下のような「第零原則」を提示しています。*3

ロボットは、人類に危害を与えることが許されず、又は、不作為によって人類が危害に遭遇する事態を許してはならない。

『われはロボット』では、USロボット社が開発・製造したロボットたちが活躍し、そのおかげで人間は宇宙にまで進出しています。しかし、それにもかかわらず人間はロボットを警戒し、ロボットとは距離をおこうとしています。

USロボット社は人間のそうした警戒心を解き、一般社会にもロボットを浸透させるため、基本的にすべてのロボットの電子頭脳に三原則を組み込んでいます。例外はあるものの、ロボットがこの原則を破ることも、第三者がそれを解除することもできません。

「第一条」をプログラミングしたら…

ロボット学者のアラン・F・T・ウィンフィールド氏は、道徳機械が実現すると確信している研究者の1人です。*1

道徳機械が守るべき倫理的規則について、同氏は三原則の第一条を挙げています。もう一度、第一条を読んでみましょう。

ロボットは人間に危害を加えてはならない。また、その危険を看過することによって、人間に危害を及ぼしてはならない。

このような規範的な道徳理論をふまえれば、ロボットは人間に悪い結果がおよぶのを防ぐはずです。そしてそのためには、倫理的規則に従うロボットが必要だという主張です。ウィンフィールド氏は、次のような実験を行いました。*4

使用したのは、人間の役割を果たす「ロボットH」と「ロボットH2」、それに、この2体を助ける役割の「ロボットA」の3体のロボット(以下、アルファベットのみ)。

ちなみに、「A」は「アシモフ(Asimov)」の頭文字に因んでいる。ロボットたちが動くフィールドには危険区域があるが、それはHとH2には認識できず、Aだけが認識可能である。Aは外界についての情報から自分の行為の結果を予想することができ、その結果が望ましいかどうかを評価することもできる。

Aの目標は、フィールドを移動して、決められた地点に到達すること。目標地点へと移動する際、Aは自らも危険区域には入らず、またHとH2が危険区域に入っていくのを阻止するようプログラミングされている。

実験結果はどうだったのでしょうか。

Aの1体だけ、あるいはAとHの2体を使った実験では、Aはプログラミングされたとおり危険区域には入らず、危険区域に向かうHの進路に入って、Hが危険区域に侵入するのを防ぐこともできました。

問題は3体で行った実験です。

AはHかH2のどちらか一方を、あるいは両方を救うことができたこともありました。

しかし半数の実験では、HとH2のどちらを助ければいいのか判断できず、2体とも危険区域に入っていくのを見すごしてしまったのです。これは、アシモフ的なロボットが陥るジレンマを再現する実験でした。

そのジレンマとはどのようなものなのでしょうか。より詳しくみていきましょう。

三原則と「道徳的ジレンマ」

冒頭でも触れたとおり、三原則は現在、自動運転の文脈で語られることがあります。

日本では道路交通法の改正により、2023年4月からレベル4(特定条件下での完全自動運転)が解禁され、国は2025年をめどに高速道路でのレベル4の実現を目指しています。*5

自動運転車が人間の命に関わる意思決定を迫られる日は、もう眼前に迫っているのです。

トロッコ問題

自動運転をめぐるロボット倫理の議論でよく言及されるものに「トロッコ問題」があります。*6 イギリスの倫理学者フィリッパ・フット氏が1967年に提起した思考実験です。

ブレーキが故障したトロッコが暴走している。もしそのまま直進すれば、その先にいる5人の作業員をひき殺してしまう。トロッコの進路を待避線に切り替えればその5人は助かるが、待避線にいる作業員1人が死ぬことになる。トロッコはそのまま進んで5人を犠牲にするべきか、それとも進路を切り替えて1人を犠牲にするべきか。

究極の二択問題。海外ではすでに自動運転による死亡事故が複数起こっている現在、これは切実な問題です。

プラットフォーム「モラルマシン」

人身事故が避けられない状況で、自動運転車はどのような倫理的意思決定をすべきでしょうか。

倫理アルゴリズムを設計するためには、皆が納得できる倫理規則を構築しなければなりません。まずはそのための議論の材料を用意しようと、MIT(マサチューセッツ工科大学)メディアラボのチームが立ち上がりました。

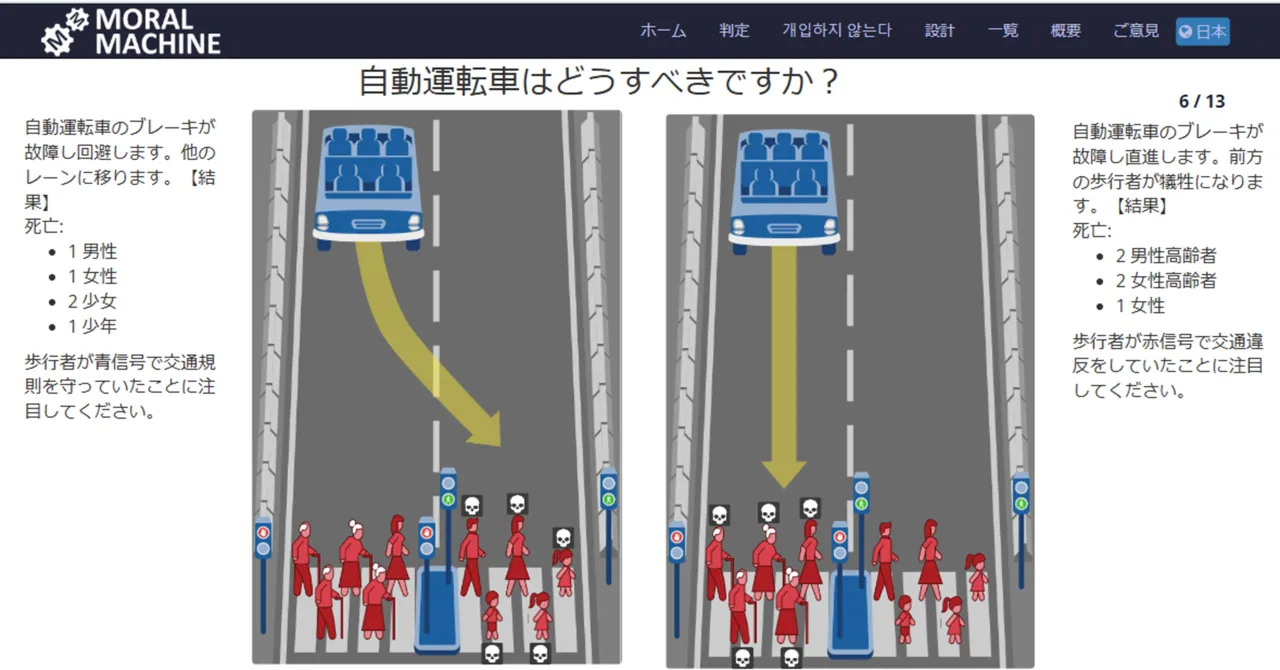

こうしてできたのが、人間の視点を収集するためのプラットフォーム「モラルマシン」です。*7

デバイスに、2車線の道路を走行する車のイラストが映し出されます。

参加者は「事故を観察する第3者」として、2つずつ示される「避けられない事故」のシナリオのうち、どちらがより容認できるか選択します。*8

13セットで1回。日本語バージョンもあります。筆者もやってみましたが、この選択はとても困難です。

命とはそれ自体が尊いもので、その重さはどれも同じ。私たちの社会は、生命の平等性を絶対的な価値観として成り立っています。ところがこの実験では、救える命と救えない命があるという前提で、どちらを救い、どちらを犠牲にするのか、命の優先順位をつけなければならないのです。

葛藤が生じ、どちらを選ぶか悩みに悩み、どちらを選んでもすっきりしません。しかし、これはもはや架空の話ではありません。

三原則は完全ではない

総務省はロボットやAI開発における原則を構築するために、以下のような検討をしました。*3

それは「トロッコ問題」に類似したシナリオに基づいています。

スクールバスが突然、自動運転車(AV)の前に飛び出して来た。AVには以下の2つしか選択肢がない。

(1) 直進して30~40名の子供とバス運転手を死なせてしまう

(2) 右折して自動運転車の乗員一名が死んでしまう

これに三原則を当てはめると、どうなるでしょうか。

どちらの選択肢を選んでも、人数にかかわらず人を殺さなければならないことになります。したがって、人間に危害を加えてはならないとする第一条に違反することになり、AVは深刻なジレンマに陥ってしまいます。

もっとも、三原則が完全でないことは『われはロボット』自体が示しています。この作品の中では、三原則が原因で困難なジレンマが生じ、ロボットたちは度々機能不全を起こしています。*1 実際、三原則は作品を面白くするために、敢えて「興味深く失敗する」ことを予期して作られているといいます。

道徳的な正しさとは何か

では、こうした道徳的ジレンマはどうやって解決したらいいのでしょうか。

そもそも、道徳的な正しさの基準とはなんなのでしょうか。

功利主義と義務論

ここで問題になるのが、功利主義と義務論の対立です。

功利主義とは、行為が人々に与える結果を重視する立場で、最大多数の最大幸福につながる行為が倫理的に正しいとする考え方です。*9 功利主義の立場からすれば、多くの人を助けることは社会的に望ましいでしょう。

一方の義務論とは、行為が人々に与える結果の善し悪しにかかわらず、世の中には守るべき義務や倫理原則があるという考え方です。義務論の立場からすれば、「人間を単なる手段として扱ってはならない」ということになるでしょう。

アメリカで1,928人を対象に行われた自動運転に関する調査では、「10人の歩行者を殺すより1人の乗員を犠牲にする方が道徳的である」との回答が76%を占めました。*10 そして、死傷者の数を最小化するようにプログラミングされた「功利主義的自動車」が道徳的に好ましいという回答が圧倒的に多かったのです。

ところが、「そうした自動車を自分が購入すると思う」という回答は半数に満たず、特に家族が同乗すると想定した場合には、「自己防衛型の自動運転車」を購入すると思うという回答が、自分だけが乗車する場合を大きく上回りました。

その調査を行った研究者は、この2つのタイプの自動運転車が発売された場合、実際に購入されるのは、乗員の保護を優先する車の方になるだろうと分析しています。

さらに、上述のプラットフォーム「モラルマシン」で集められた4,000万件のデータのうち、回答者が100人以上の130か国のデータを分析したところ、文化圏によって倫理観が異なっていたことが報告されています。*11

道徳的な正しさに、唯一無二の正解はないのです。

『われはロボット』が投げかける問い

国はレベル4の社会実装を念頭におき、トロッコ問題のような「どちらの判断をしても被害が生じる場合」を対象に、社会が受け入れ可能なシステムの責任範囲や判断のあり方についての検討に乗り出しました。この事業には、2024年度、2億3,100万円の予算をつけています。*12, *13

アシモフのロボット工学三原則は、人間とロボットの関係における基本的な倫理原則として大きな影響を与えてきました。しかし、自動運転車の社会実装に向けて、三原則だけでは対応できない複雑な問題が浮上しています。

特にトロッコ問題のような道徳的ジレンマは、ロボットにどのような価値観を組み込むべきかという根源的な問いを投げかけています。

アシモフの『われはロボット』にみられるジレンマは、70年以上の時を経ていよいよ現実のものとなりつつあるのです。

資料一覧

*1 マーク・クーケルバーグ著 田畑暁生 訳(2024)『ロボット倫理学 ソーシャルロボットから軍事ドローンまで』青土社 pp.91-92,94

*2 アイザック・アシモフ『われはロボット〔決定版〕』(2014)早川書房(電子書籍版)No.17

*3 総務省「AI NW研究開発8原則とロボット工学三原則」(開発原則分科会 第1回)p.3,6,7

*4 久木田水生「第1章 機械の中の道徳」(『ロボットからの倫理学』(2017)名古屋大学出版会 pp.8-9

*5 出所)国土交通省「自動運転の実現に向けた取り組みについて」(2023年5月)p.2

*6 遠藤薫「善きAI社会をめざして— ポストヒューマンの時代を考える —」(『学習院大学 法学会雑誌』57巻2号)(2022年)p.52

*7 nature asia「【人工知能】自動運転車が従うべき道徳的規則とは」

*9 相馬正史・都築誉史「道徳的ジレンマ状況における意思決定研究の動向」(Rikkyo Psychological Research 2013, Vol.55)p.68

*10 佐藤英明「自動運転車とトロリー問題」(2020)p.27