- 総合TOP

- 宇宙

- AI

- ロボット

- WEB3・メタバース

2024年11月13日、「NVIDIA AI Summit 2024」でAI時代の産業変革に向けた新たな取り組みが発表された。ソフトバンク、GMOインターネットグループ、ハイレゾ、KDDI、RUTILEA、さくらインターネットが、エヌビディアのアクセラレーテッド コンピューティング、ネットワーキング、ソフトウェアを活用してAIインフラを構築。日本におけるロボティクス、自動車、ヘルスケア、通信、公共部門の発展を推進していくというものだ。詳細に迫った。(文=RoboStep編集部)

ロボティクスの課題を解決するAIインフラ

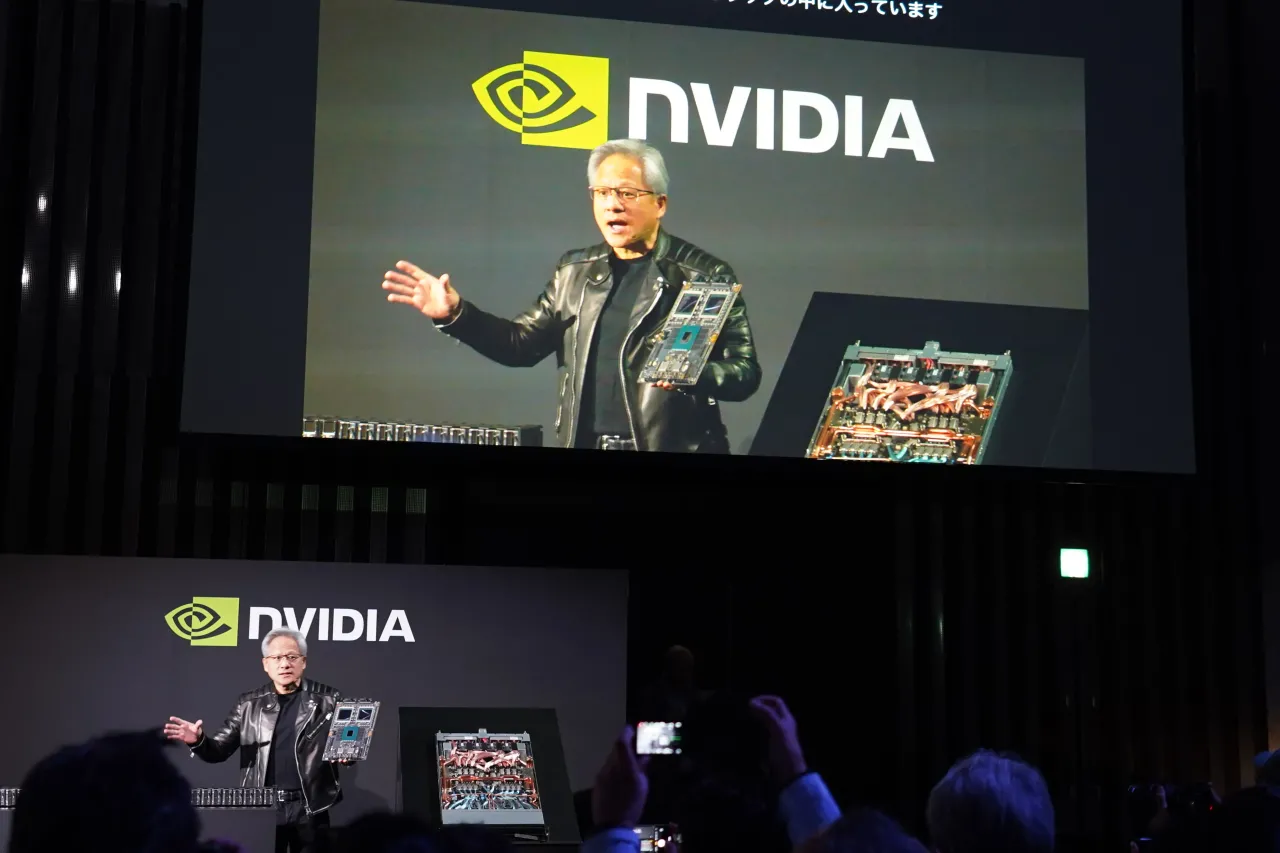

基調講演にも登壇したエヌビディアの創業者/CEO ジェンスン ファン氏は、今回の取り組みについてこう語る。

「日本は数十年にわたり、優れた技術力を発揮しており、AI産業革命における驚異的な変革を後押ししています。エヌビディアと連携し、日本のクラウドプロバイダーは自動車、ロボティクス、通信、ヘルスケアなどにおける日本のリーダーシップを高め、世界中の市民と顧客が直面する最も差し迫った課題を解決するために、AIインフラを構築しています」(ファン氏)

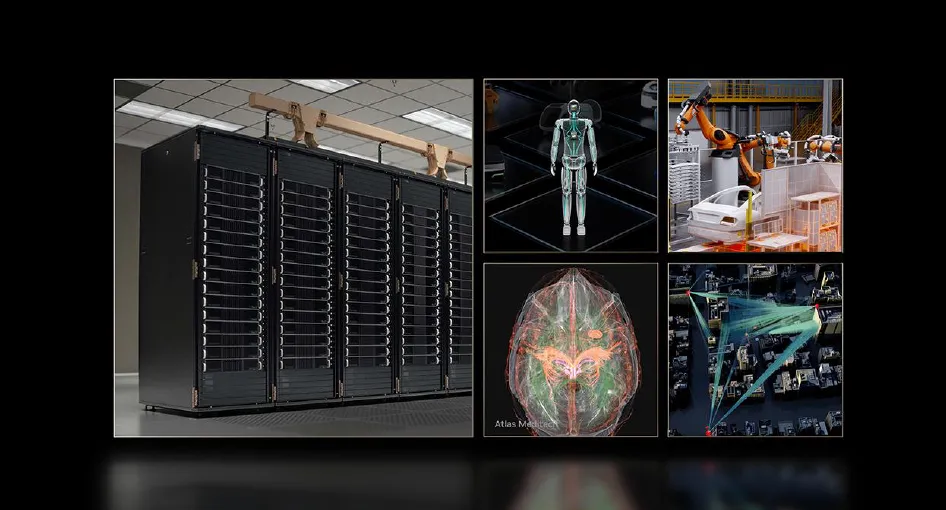

日本のクラウドプロバイダーサービスは、業界全体に重要なコンピューティングサービスを提供するため、経済産業省のプログラムを通じて支援されている。クラウドプロバイダーは、国内の各地にAIデータセンターを運営しているが、ここで何万基ものNVIDIA GPUが増強され、国と地域のコンピューティングインフラを強化。AI開発を支援している。

例えばソフトバンクは、AIスーパーコンピューターを構築するために、現時点での最新のGPU、NVIDIA Blackwellプラットフォームを採用。DGX B200システムで構成された世界初のNVIDIA DGX SuperPODも含まれるという。

ファン氏は「BlackwellプラットフォームはGPUのチップだけを指しません。高速メモリやインタフェース、サーバー間をつなぐスイッチなどを含めたAIシステムがBlackwellなのです」と語る。

GMOインターネットグループは、Dell PowerEdgeサーバー上に構築され、NVIDIA H200 Tensor コア GPU、AI向けのNVIDIA Spectrum-X Ethernetプラットフォーム、NVIDIA BlueField-3 DPU、NVIDIA AI Enterpriseソフトウェアスイートをフルスタックで搭載した日本発のローカルクラウドサービス「GMO GPU クラウド」を2024年11月から提供を開始。ユーザーは、NVIDIA AI Enterpriseソフトウェアを利用し、本場環境で稼働する生成AIアプリケーションを高速化することができるようになる。

日本におけるAI開発のインフラが充実

ハイレゾは、AIデータセンター「ハイレゾ香川」を設立。日本でのAI開発を加速しているが、ここにもNVIDIA H200 TensorコアGPUを採用。2024年12月には「GPUSOROBAN」AIスパコンクラウドのサービスを開始する予定だ。2025年には、2つ目のAIデータセンターを稼働開始予定だという。日本の大都市圏以外におけるAI開発が促進されることが期待される。

生成AIの進化がロボティクス産業を加速するとも言われる。AI開発のインフラに注目が集まる所以だ

生成AIの進化がロボティクス産業を加速するとも言われる。AI開発のインフラに注目が集まる所以だ

KDDIは、大規模言語モデルの開発・導入を手掛けるELYZAと連携し、生成AIと専門のLLMの開発をサポートするため、NVIDIA HGXシステムで構築されたAIコンピューティングインフラを立ち上げている。こうしたインフラを活用し、AIトレーニングと推論を高速化し、デジタルツインを構築すればロボットの動作制御や自立走行車、センサーデータ処理のシミュレーションワークロードが実行できるようになる。

「AIを簡単に。」をビジョンに掲げるスタートアップ企業RUTILEAは、1,000基以上のNVIDIA Hopper GPUを提供し、アニメーション、小売・食品サービス、ビジョンベースの編集、データ抽出向けの基盤モデルの構築をサポート。LLM(大規模言語モデル)開発にも活用されている。

さくらインターネットは、生成AI向けクラウドサービス「高火力」のNVIDIA Hopper GPUを2,000基から4,000基近くにまで拡大する予定だという。同社は、2027年までに北海道に所有する再生可能エネルギー100%で運用する石狩データセンターにBlackwell GPUを搭載したNVIDIA HGX B200をはじめとするGPUを整備する予定だという。同社の顧客には、公的研究機関である国立情報学研究所(NII)があるが、NIIは、大規模言語モデル研究開発センター(LLM研究開発センター)を設立し、日本語医療LLMの研究開発を進める。